Era una reunión rutinaria de equipo. La directora de marketing presentaba la nueva campaña de contenidos generados con IA: imágenes espectaculares, vídeos personalizados, copys adaptados a cada segmento. Todo parecía perfecto hasta que el responsable legal levantó la mano.

«¿Cómo vamos a etiquetar esto para cumplir con el AI Act?»

Silencio incómodo. Miradas confusas. Nadie en la sala sabía de qué estaba.

La fecha que todo el mundo ignora (pero no debería) 2 de agosto de 2026

En menos de un año, cualquier empresa que opere en la Unión Europea deberá etiquetar de forma explícita todo contenido creado o manipulado por inteligencia artificial. No se trata de una recomendación ni de una buena práctica. Es ley europea, con multas que pueden alcanzar los 15 millones de euros o el 3% de la facturación global anual de la empresa, lo que sea mayor.

El artículo 50 del EU AI Act establece que las empresas deben informar a los usuarios cuando interactúan con un sistema de IA, y los sistemas que generan contenido sintético como deepfakes deben marcar sus salidas como artificialmente generadas. Las reglas de transparencia del AI Act entrarán en vigor en agosto de 2026.

Y aquí viene lo interesante: no basta con poner un asterisco discreto en la esquina. El AI Act exige un sistema dual: etiquetado técnico legible por máquinas y divulgación transparente del origen artificial del contenido.

El estándar que nadie esperaba: C2PA

Cuando la normativa menciona «etiquetado técnico legible por máquinas», se refiere a estándares como el C2PA (Coalition for Content Provenance and Authenticity). C2PA proporciona un estándar técnico abierto para que editores, creadores y consumidores establezcan el origen y las ediciones del contenido digital.

Imaginemos el C2PA como la «etiqueta nutricional» del contenido digital. Permite mantener la procedencia del activo a través de múltiples herramientas, desde la creación hasta todas las modificaciones posteriores y publicación o distribución.

¿Cómo funciona? El sistema incluye una serie de declaraciones llamadas afirmaciones (assertions) que cubren áreas como la creación del activo, acciones de edición, detalles del dispositivo de captura y vínculos con el contenido. Estas afirmaciones se envuelven con información adicional en una entidad firmada digitalmente llamada reclamación (claim).

En términos prácticos:

- Metadatos firmados criptográficamente sobre quién creó el contenido y cuándo ● Marcas de agua robustas que persisten incluso tras ediciones o compresiones ● Huellas digitales que permiten verificar autenticidad

- Cadena de custodia completa: cada edición, cada transformación queda registrada

Crucialmente, la especificación C2PA no proporciona un juicio de valor sobre si un conjunto de datos es «verdadero» o «confiable», sino que proporciona una forma segura de asociar información de procedencia a un activo digital.

¿Por qué esto importa ahora?

Porque agosto de 2026 puede parecer lejano, pero preparar una organización para este nivel de cumplimiento normativo no es trivial. Requiere:

- Auditoría completa de sistemas de IA

Identificar todos los puntos donde tu organización genera, modifica o distribuye contenido mediante IA. Eso incluye chatbots, generadores de imágenes, sistemas de traducción automática, herramientas de escritura asistida, edición de vídeo, síntesis de voz, y un largo etcétera.

- Integración técnica de capacidades de etiquetado

Implementar C2PA u otros estándares compatibles no es plug-and-play. Implica modificar pipelines de producción de contenido, integrar bibliotecas de firma digital, establecer

certificados y claves criptográficas, y asegurar que toda la cadena de producción respete el etiquetado.

- Establecimiento de procesos de gobernanza

El Recital 136 del AI Act enfatiza el papel crucial de la detección y divulgación de contenido manipulado tanto por proveedores como por implementadores de «ciertos» sistemas de IA. Esto significa definir quién es responsable de qué, establecer protocolos de revisión y crear documentación auditable.

- Formación organizacional

Los equipos necesitan entender no sólo cómo etiquetar el contenido, sino por qué es importante, cuándo es obligatorio y qué excepciones existen. El AI Act incluye una exención para obras evidentemente artísticas, creativas, satíricas, ficticias o similares, que permite que la divulgación se realice de manera que no obstaculice la exhibición o disfrute de la obra.

- Infraestructura de monitorización continua

El cumplimiento no es un proyecto puntual. Necesitas sistemas que garanticen que cada pieza de contenido generado por IA esté correctamente etiquetada, hoy y dentro de dos años.

El problema estructural: la IA como «feature» vs. la IA como infraestructura

Aquí está el quid de la cuestión que muchas organizaciones no han captado todavía: la forma en que implementas IA determina tu capacidad de cumplir con la normativa.

Si has adoptado IA como un conjunto de herramientas dispersas —ChatGPT aquí, Midjourney allá, un chatbot por este lado, un generador de copys por el otro— vas a tener un problema serio. Cada punto de entrada de IA es un punto de riesgo de incumplimiento.

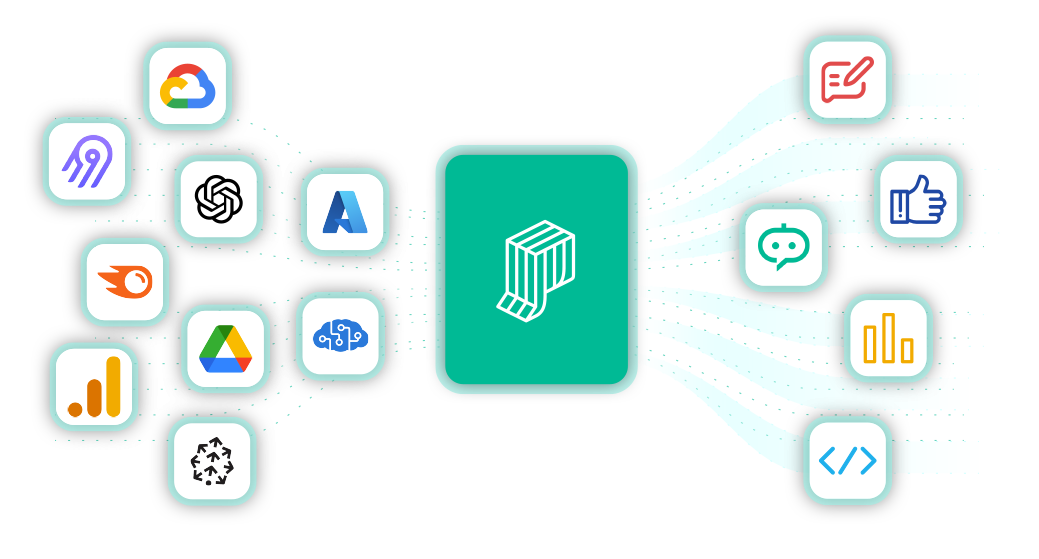

Necesitas infraestructura agéntica: una capa de orquestación que gestione de forma unificada todos tus agentes de IA, con:

- Trazabilidad completa: cada interacción registrada, cada modelo utilizado documentado

- Control de acceso granular: quién puede usar qué agente y con qué datos ● Guardrails de seguridad y privacidad: filtros que aseguren que los agentes no generen contenido inapropiado ni expongan datos sensibles

- Monitorización centralizada: visibilidad total sobre uso, costes y cumplimiento ● Agnóstico de proveedor: capacidad de cambiar de modelo o proveedor sin rehacer toda la arquitectura

Tres tipos de empresas frente a las leyes de IA de agosto 2026

En conversaciones con organizaciones de toda Europa, estoy viendo emerger tres perfiles claramente diferenciados:

Tipo 1: Los dormidos

Ni siquiera saben que existe esta obligación. Siguen usando IA de forma ad-hoc, sin controles, sin registros, sin preparación. Cuando llegue agosto de 2026, entrarán en pánico.

Tipo 2: Los reactivos

Saben de la normativa pero piensan «ya lo resolveremos cuando llegue el momento». Creen que será cuestión de añadir un disclaimer en el footer. Van a descubrir que es mucho más complejo.

Tipo 3: Los estratégicos

Han entendido que el compliance no es solo evitar multas, sino una oportunidad de diferenciación. Están construyendo infraestructura responsable de IA desde ahora, con transparencia y gobernanza desde el diseño.

¿En qué categoría está tu organización?

Más allá del compliance: transparencia como ventaja competitiva

La Comisión está promoviendo el AI Pact, buscando el compromiso voluntario de la industria para anticipar el AI Act y comenzar a implementar sus requisitos antes de la fecha límite legal.

Las empresas que adopten prácticas de transparencia en IA ahora, antes de que sea obligatorio, van a:

- Generar mayor confianza con clientes, inversores y stakeholders 2. Evitar sanciones millonarias y crisis reputacionales

- Adelantarse a la competencia en madurez de IA

- Establecer procesos escalables para futura normativa (porque el AI Act es solo el principio)

La transparencia en el uso de IA no es un coste, es una inversión en legitimidad y sostenibilidad a largo plazo.

El ecosistema C2PA: quién está construyendo el futuro

C2PA es un proyecto de la Joint Development Foundation, formado a través de una alianza entre Adobe, Arm, Intel, Microsoft y Truepic. La especificación C2PA es el resultado de colaboraciones en toda la industria centradas en la transparencia de medios digitales que acelerarán el progreso hacia la adopción global de la procedencia del contenido.

Grandes plataformas ya están implementando soluciones:

- Google anunció que etiquetará imágenes generadas por IA que aparezcan en los resultados de su motor de búsqueda

- TikTok y Meta ya han aplicado reglas específicas para frenar el uso indebido de la IA ● Los proveedores de modelos de IA generativa deben asegurar que el contenido generado esté sistemáticamente marcado

La pregunta que deberías hacerte hoy

No es «¿cómo cumplo con el AI Act?», sino:

«¿Cómo construir una organización donde la IA sea una ventaja competitiva sostenible, transparente y responsable?»

Porque el deadline de agosto de 2026 es real. Las multas son reales. Pero más allá de eso, la pregunta de fondo es sobre qué tipo de organización quieres ser en la era de la IA.

¿Una que reactiva, que cumple a regañadientes y ve el compliance como una carga?

¿O una que es proactiva, que construye desde la transparencia y convierte la responsabilidad en IA en parte de su propuesta de valor?

Tres acciones concretas para esta semana

Si después de leer esto sientes que tu organización necesita moverse, aquí van tres pasos inmediatos:

- Audita tu exposición: haz un inventario de todos los sistemas de IA que generan o manipulan contenido en tu organización. Puede que te sorprenda cuántos son. 2. Evalúa tu arquitectura actual: ¿tienes trazabilidad? ¿Puedes demostrar qué contenido fue generado por IA y cuál no? ¿Tienes control centralizado o todo está disperso?

- Define un responsable de AI Governance: el compliance del AI Act no puede ser responsabilidad de nadie en general. Alguien tiene que liderar esto, con autoridad y presupuesto.

Reflexión final

El EU AI Act representa el primer marco legal integral sobre inteligencia artificial en el mundo. Europa no solo está regulando la IA, está definiendo los estándares globales de cómo debe usarse de forma responsable.

El objetivo de las reglas es fomentar la IA confiable en Europa. Y esa confianza se construye sobre transparencia.

Agosto de 2026 es el deadline. Pero la preparación empieza hoy.

Porque en el fondo, esto no va de cumplir con una ley. Va de construir el tipo de futuro digital en el que queremos vivir.

¿Tu organización está preparada? ¿Conocías esta obligación? ¿Estás trabajando ya en la preparación para el AI Act?

Si necesitas asesoramiento en esto, contáctanos.